1 En local

Par défaut, l'application exécute les taches d'encodage et de transcription sur la même machine que celle sur laquelle elle tourne.

Si l'encodage et la transcription sont effectués sur la même machine que le frontal, leur execution est "threadée" (exécuté dans un sous processus).

Pour l'xAPI, le nombre de requête oblige à déporter son traitement sur une autre machine.

Pour configurer ces taches et leur execution, vous pouvez vous reporter sur le fichier de configuration disponible à cette adresse : https://github.com/EsupPortail/Esup-Pod/blob/master/CONFIGURATION_FR.md

2 Déporté sur une machine distante

Vous pouvez déporter l'encodage, la transcription et le traitement de l'xAPI sur des environnements distants (VM ou Docker) avec soit un seul environnement pour les 3 taches, soit "n" environnements pour chaque tache.

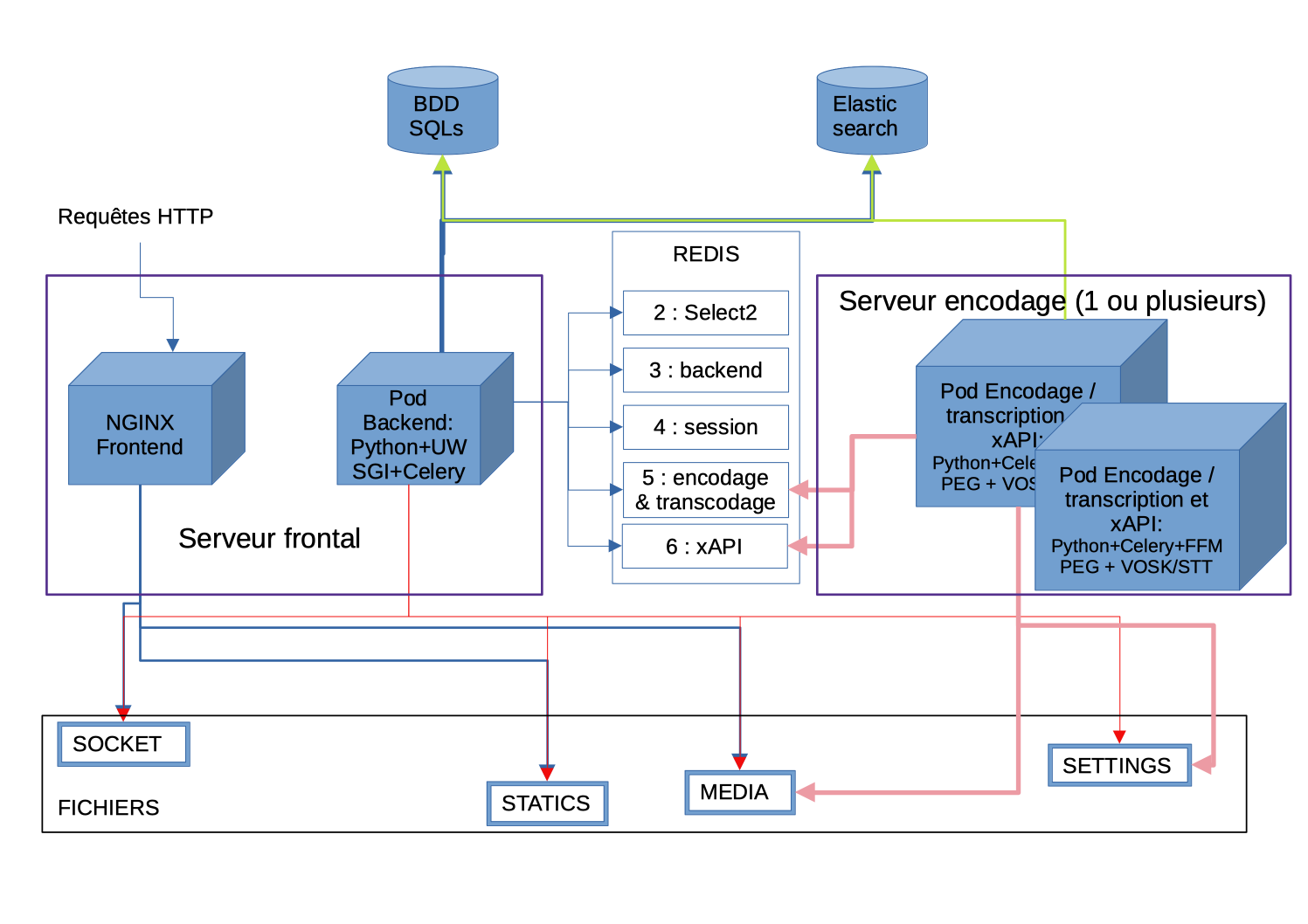

le déport actuel se fait selon le schéma suivant :

- Déporter l'encodage sur un ou plusieurs serveurs en Pod V3

- Installation de l'autotranscription en Pod V3 (avec possibilité de déport sur le serveur d'encodage)

- Mise en place de l'xAPI sur le serveur d'encodage

3 Déporté sur une machine ou un docker en microservice

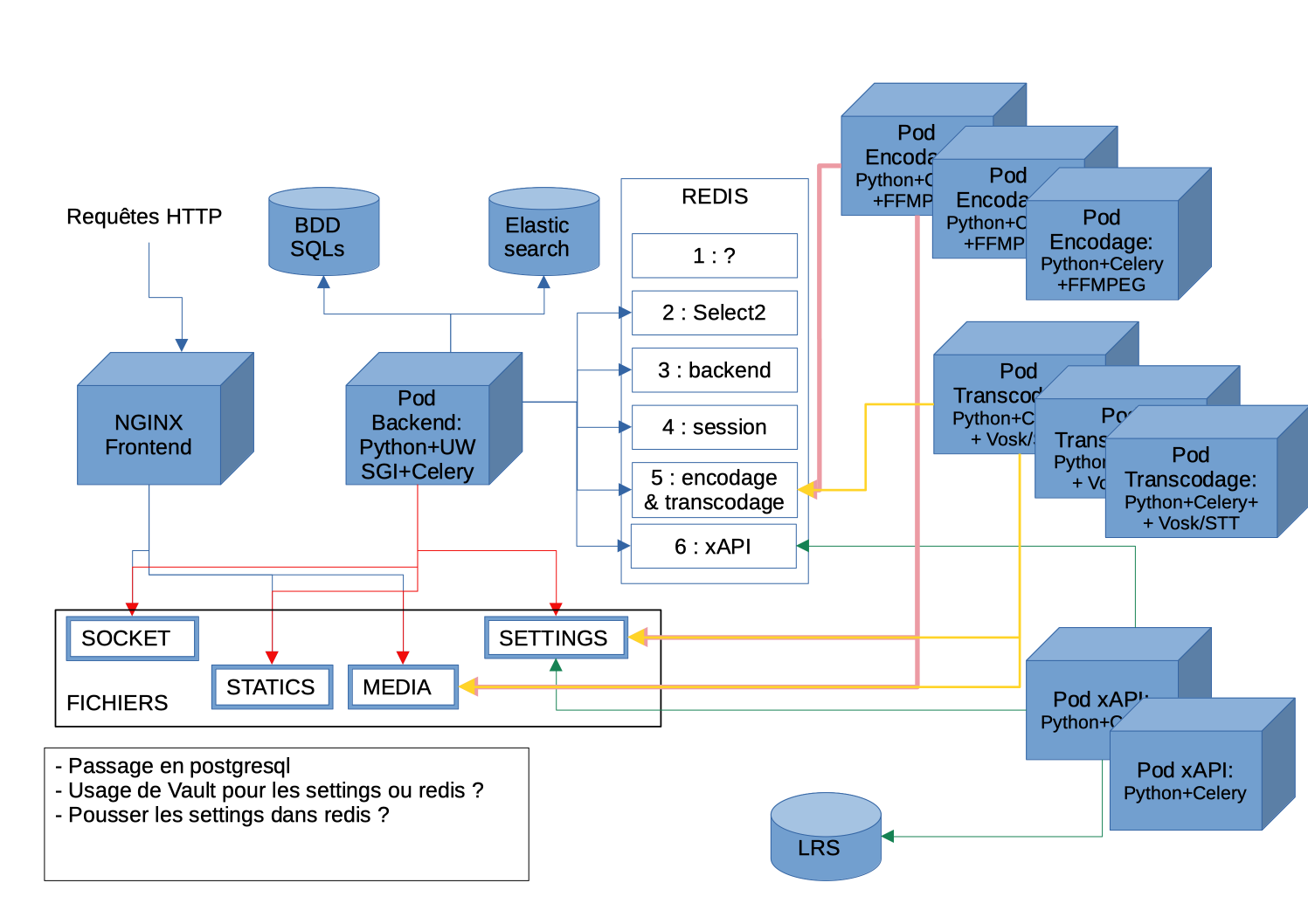

Depuis la version 3.4.0, il est possible de déporter l'encodage, la transcription et l'xAPI en micro-service. Ces microservices sont autonome et ne nécessite pas de lien avec la base de données ou le moteur de recherche comme précédemment.

Cela se faite selon le schéma suivant :

Vous avez des dockerfiles pour chaque microservice à disposition dans le code source de Pod :

- Encodage : (lien à venir)

- Transcription : (lien à venir)

- xAPI : (lien à venir)

Il faut que chaque service ait accès au même espace de fichier Pod (espace partagé) et accès à Redis qui va jouer de role de file d'attente pour les taches d'encodage, de transcription ou d'envoi xAPI.